Ein Nachrichten Blog von Rudi Kulzer

Hewlett-Packard hat am 1. November 2011 für einige der weltweit größten Rechenzentren ein neues Server-Design angekündigt. Damit soll der Stromverbrauch in einigen Fällen um 90 Prozent reduziert werden.

HPs neues Entwicklungsprogramm mit dem Namen „Project Moonshot“ hat das Ziel, die Komplexität, den Energieverbrauch und die Kosten der IT-Infrastruktur deutlich zu reduzieren. Es umfasst eine Server-Entwicklungsplattform, ein Testlabor für Kunden und ein Partner-Programm.

Project Moonshot richtet sich an Unternehmen, die tausende von Servern betreiben und darüber beispielsweise Web-Dienstleistungen oder Social-Media-Anwendungen bereitstellen. HP will mit der Initiative die Zusammenarbeit innerhalb der Branche fördern, um neue Wege bei „hyperskalierbaren“ Rechenumgebungen wie Cloud-Services und On-Demand-Computing zu beschreiten.

HP erwartet, mit Project Moonshot die Effizienz von ausgewählten Arbeitslasten und Anwendungen deutlich zu verbessern: Im Vergleich zu konventionellen Server-Systemen sollen der Energieverbrauch um bis zu 89 Prozent, der Platzbedarf um bis zu 94 Prozent und die Gesamtkosten im Rechenzentrum um bis zu 63 Prozent sinken.

Das „Project Moonshot“ genannte Design arbeitet mit einem Konzept, bei dem die herkömmliche Mikroprozessoren in Servern durch Handy- oder Notebooks-Chips ersetzt werden. Da der Stromverbrauch in mobilen Geräten, die auf kleinen Batterien laufen, per se niedrig gehalten werden muss, sind diese Prozessoren von Grund auf so konzipiert, dass sie möglichste wenig Strom verbrauchen. So schalten sie etwa automatisch bei bestimmten Aufgaben ab oder verlangsamen den Verbrauch bei Anrufen oder Web-Aktionen.

„Unternehmen mit Hyperscale-Umgebungen stehen vor ernsthaften Kapazitätproblemen, die einen grundlegenden Umbau der IT-Architektur erfordern“, sagt Paul Santeler, Vizepräsident und General Manager der Hyperscale Business Unit, HP Industry Standard Servers and Software. Im Moment sei das Projekt ein Service für etwa 50 der weltweit größten Online-Unternehmen, so Santeler weiter. Nach seiner Ansicht macht das für diese Provider, deren Web -Architektur unzählig viele User bedient, sehr viel Sinn. Täglich kämen derzeit weltweit etwa 7.000 Computer-Servern zum großen Portfolio, die meisten für Web-Aktivitäten wie Social Networking und Videowiedergabe.

Künftig könnten derartig ausgerüstete Server-Rechner auch Finanzunternehmen, wissenschaftliche Forscher und Sicherheitskräfte von Regierungen und Organisationen interessant sein, die in ihrem Aufgabengebiet größere Datenmengen verarbeiten müssen, so Santeler. Die Entwicklung zu solchen Chips ist zwar schon mehrfache vorausgesagt worden. HP ist aber das erste große Computer-Unternehmen, das nun ein kommerzielles Produkt anbietet.

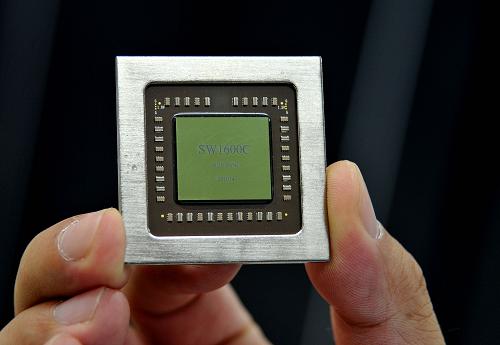

Energiesparender ARM Chip Quelle: Werkfoto

Das neue Design verwenden Chips von Calxeda aus Austin,Texas. einem Spezialist für low-power ARM-Chips für Server. HP will den Verkauf von „Moonshot-Computern“ ab etwa Mitte-2012 startet. Derzeit überlegt man noch in welchem Preissegment derartige Rechner angeboten werden sollen.

Nach dem aktuellen Stand ist „Project Moonshot“ ein mehrjähriges Programm, das aus mehreren Phasen besteht. Es baut auf zehn Jahren Forschung der HP Labs im Bereich Niedrigenergie-Computing auf.

Projekt Moonshot unterstützt die Entwicklung der Branche in Richtung Hyperscale Computing mit drei wesentlichen Elementen:

– Die HP Redstone Server Development Platform ist die erste einer Reihe von HP-Server-Entwicklungsplattformen mit Niedrigenergie-Prozessoren. HP Redstone nutzt zunächst die Prozessoren Calxeda EnergyCore ARM Cortex und ist für Test- und Machbarkeitsnachweise entworfen. Künftige Redstone-Versionen werden unter anderem mit Intel-Atom-Prozessoren arbeiten. Die Redstone-Plattform umfasst mehr als 2.800 Server in einem einzigen Rack. Das reduziert den Verkabelungsaufwand, die Anzahl der Switches und Peripheriegeräte und verringert die Komplexität um 97 Prozent. Die erste HP-Redstone-Plattform ist für ausgewählte Kunden voraussichtlich ab Mitte nächsten Jahres in begrenztem Umfang erhältlich.

HP Entwicklungsplattform Redstone Quelle: Werkfoto

– Das Testcenter HP Discovery Lab ermöglicht es Kunden, Anwendungen auf der HP-Redstone-Plattform, anderen Niedrigenergie-Plattformen oder auf herkömmlichen Servern zu testen und zu vergleichen. Das erste HP Discovery Lab soll im Januar 2012 in Houston eröffnet werden, weitere Standorte in Europa und Asien sollen folgen. Per Fernzugriff oder Zugriff vor Ort können Kunden in den Laboren direkt mit HP-Ingenieuren und Branchenkollegen zusammenarbeiten und so über die Vorteile der Niedrigenergie-Server sprechen.

– Das HP Pathfinder Program ist Teil des HP-AllianceONE-Partnerprogramms. Es umfasst Softwarehersteller sowie Server-, Speicher- und Netzwerk-Partner, die Hardware-, Software- und technische Expertise einbringen. Zu den ersten Teilnehmern sollen AMD, ARM Holdings, Calxeda, Canonical und Red Hat zählen. Das HP Pathfinder Program soll unter anderem dafür sorgen, dass die Elemente des Programms Project Moonshot im Rahmen von offenen Industriestandards weiterentwickelt werden.

Darüberhinaus beruhe das Projekt auf HPs Erfahrungen mit Rechenzentrum HP EcoPod und HP Data Center Smart Grid. Die Project-Moonshot-Infrastruktur ist einer Erweiterung der bestehenden ProLiant-Serverserie, die x86-Prozessoren von Intel und AMD nutzt.